多模态模子学会打扑克:说明罕见GPT-4v,全新强化学习框架是要道

Simon Zhai 投稿

量子位 | 公众号 QbitAI

只用强化学习来微调,无需东说念主类反应,就能让多模态大模子学会作念方案!

这种智商得到的模子,照旧学会了看图玩扑克、算“12点”等任务,说明以至罕见了GPT-4v。

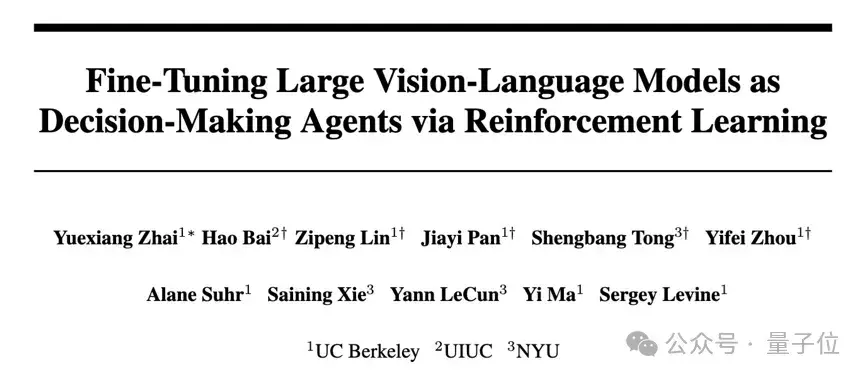

这是来自UC伯克利等高校最新建议的微调智商,连络威望亦然绝顶豪华:

图灵奖三巨头之一、Meta首席AI科学家、纽约大学栽种LeCunUC伯克利大牛、ALOHA团队成员Sergry LevineResNeXt一作、Sora基础本事DiT作家谢赛宁香港大学数据科学学院院长、UC伯克利栽种马毅

该智商名为RL4VLM,论文预印本照旧上线,联系代码也已在GitHub中开源。

RL4VLM建议了一种新的算法框架,径直使用强化学习智商对多模态大模子进行微调。

其中奖励信息径直开头于环境当中,解脱了RLHF中关于东说念主类反应的需要,从而径直赋予了多模态模子方案材干。

关于RL4VLM的真谛,参与了这项使命的马毅栽种这么说:

一方面但愿公共对模子实在性能有更客不雅清醒的意志;

另一方面,也但愿能拓荒一个平台,复古探索若何进一步升迁模子性能。

那么,用这种智商微调出来的多模态大模子,王人能让智能体学会哪些材干呢?

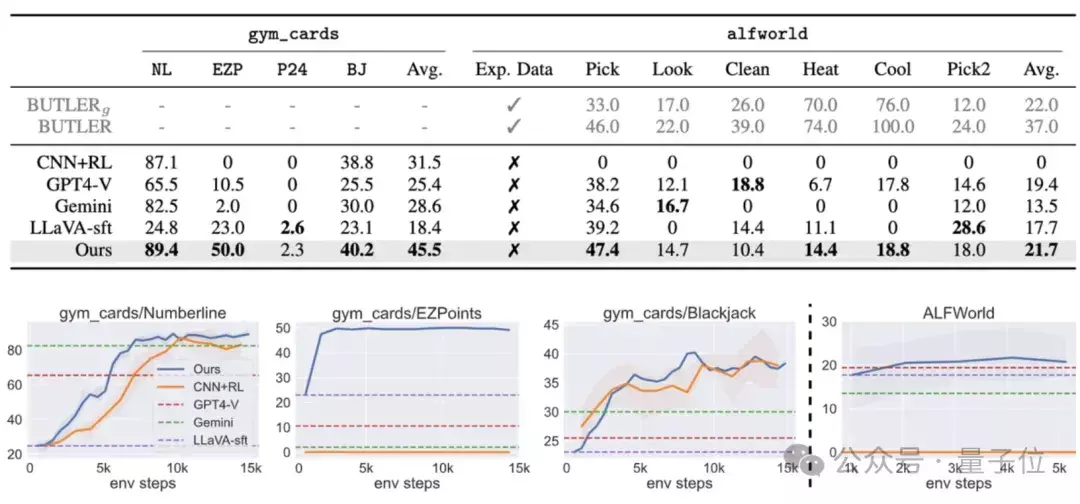

多模态方案材干超GPT-4v为了评估考验出的多模态大模子给智能体带来的材干,作家一共使用了两类物种评测任务:

第一类任务(a-d) 主要考验模子利用图像中的细粒度视觉信息作念方案的材干,包括关于数字的识别材干和利用识别的数字进行逻辑推理的材干第二类任务(e)主要考验多模态大模子在具身智能环境中的视觉语义推理材干。具体来说,这五个任务折柳是:

a.数轴(Numberline):模子需要通过输出“+” 或者 “-”,将现时数字搬动到想法数字b.粗略12点(EZPoint):模子需要识别两张牌,并用加号和乘号运算“12点”c.24点(Point24): 模子需要识别四张牌,并用加减乘除和括号运算“24点”d.21点(Blackjack):模子需要通过牌面上的信息来决定“要牌”或者“停牌”e.ALFWorld:一个挨次具身智能环境

其中任务a-d为作家的原创任务,任务e的ALFWorld是微软就是2020年建议的开源具身智能任务集。

践诺遵守标明,径直使用强化学习微调7B的多模态模子之后,能使其在两类方案问题上的说明进步商用模子GPT-4v Gemini,同期也能进步传统的监督微调(SFT)智商。

而在ALFWorld的具身智能任务中,作家的模子也取得了最高的平平分,极端是在单物体拾取任务上说明尤为杰出。

先生成想维链,再作念方案

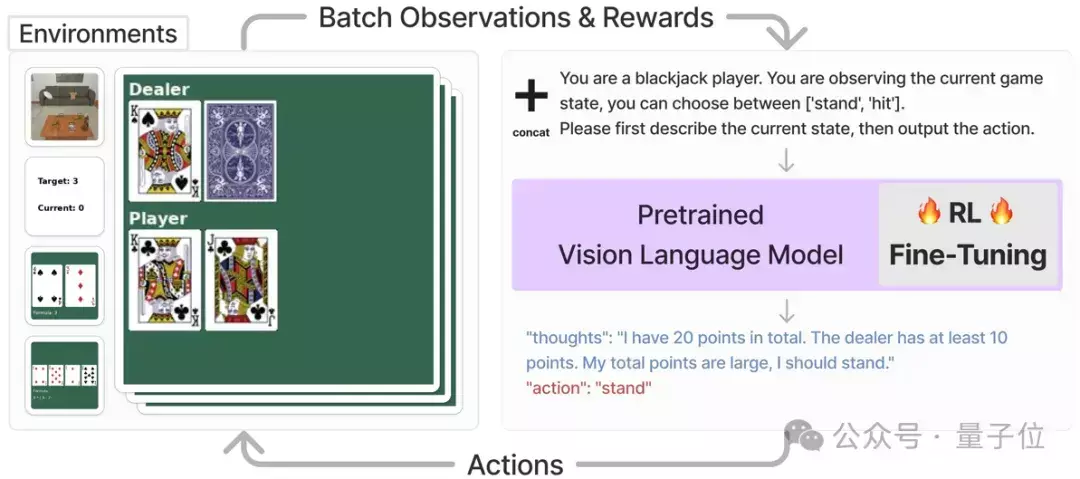

先生成想维链,再作念方案这套VLM智能体主要惩办的是需要视觉识别和说话剖释的任务,它的使命经由是这么的:

领先,关于每一个任务,系统会径直将该任务确现时景色,以图片和笔墨描述的格局输入多模态大模子,并条款模子输出一段想维链之后,再以笔墨格局输出要扩张的动作。

临了将,动作信息会被输入进对应的环境并赢得奖励值,该奖励值会被用来进行强化学习考验。

举例下图中,智能体在扩张玩21点的任务时,系统径直条款多模态模子凭证当今的景色,在输出想维链之后给与“停牌” (stand)或者“拿牌”(hit),然后径直将对应的动作输入到环境中,得到奖励函数值以及下一个景色。

为了能用径直坚硬化学习行使到多模态模子的考验中,需要对模子的输入和输出作念一些更始,以适宜RL考验框架中。

具体来说,作家将任务图像o和任务描述的文本v-in肃清后,径直手脚现时任务的景色s,即:

s = [o, v-in]

在赢得了多模态模子的笔墨输出v-out以后,该框架径直将其中笔墨格局的动作(“action: {act}”) 升沉为可与环境交互的动作指示a。

接下来把a输入到环境当中,就能赢得奖励函数r,以及操作后的下一个景色。

在赢得了来自环境的奖励函数r之后,著作利用PPO径直对统共多模态模子进行微调。

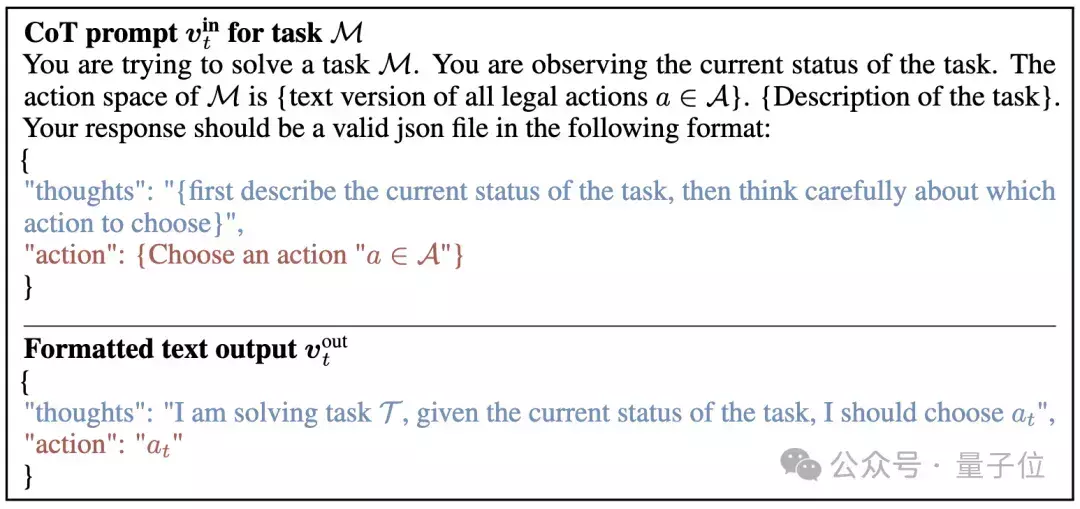

而从教导词上看,这项连络采纳了如下的教导过程手脚多模态模子的输入,况兼给出了祈望的输出格局:

(其中蓝色的部分是让模子生成想维链教导过程, 红色的部分是告诉模子以笔墨格局输迁徙作a)

消融践诺遵守标明,若是这一过程中不采纳想维链,则任务告捷率会出现大幅下跌。

论文地址:

https://arxiv.org/abs/2405.10292GitHub:https://github.com/RL4VLM/RL4VLM— 完 —

量子位 QbitAI · 头条号签约

","del":0,"gnid":"9312d6c03e38dd857","img_data":[{"flag":2,"img":[{"desc":"","height":"488","s_url":"http://p2.img.360kuai.com/t110df81bbcb82f9a8b5f3b5a7c_1.gif","title":"","url":"http://p2.img.360kuai.com/t110df81bbcb82f9a8b5f3b5a7c.gif","width":"1078"},{"desc":"","height":"378","title":"","url":"http://p2.img.360kuai.com/t110df81bbce8665081073bad19.webp","width":"867"},{"desc":"","height":"360","s_url":"http://p2.img.360kuai.com/t110df81bbc101e55a293e8f4e5_1.gif","title":"","url":"http://p2.img.360kuai.com/t110df81bbc101e55a293e8f4e5.gif","width":"640"},{"desc":"","height":"391","title":"","url":"http://p1.img.360kuai.com/t110df81bbcc633a562b164d0a8.webp","width":"1080"},{"desc":"","height":"266","title":"","url":"http://p0.img.360kuai.com/t110df81bbcbe60cd9250e37465.webp","width":"1080"},{"desc":"","height":"504","title":"","url":"http://p2.img.360kuai.com/t110df81bbc68e658eab3116b16.webp","width":"1080"},{"desc":"","height":"479","title":"","url":"http://p2.img.360kuai.com/t110df81bbc177c7556ce3e5aee.webp","width":"1080"},{"desc":"","height":"509","title":"","url":"http://p0.img.360kuai.com/t110df81bbcac4821f3e75e0be2.webp","width":"1080"},{"desc":"","height":"412","title":"","url":"http://p2.img.360kuai.com/t110df81bbca3b2ff4f59b2637d.webp","width":"1080"}]}],"original":0,"pat":"art_src_3,fts0,sts0","powerby":"cache","pub_time":1717485060000,"pure":"","rawurl":"http://zm.news.so.com/597cd3112e8c51e4332c478d251383e1","redirect":0,"rptid":"de306343aae354da","rss_ext":[],"s":"t","src":"量子位","tag":[{"clk":"ktechnology_1:伯克利","k":"伯克利","u":""}],"title":"多模态模子学会打扑克:说明罕见GPT-4v,全新强化学习框架是要道","type":"zmt","wapurl":"http://zm.news.so.com/597cd3112e8c51e4332c478d251383e1","ytag":"科技:东说念主工智能:AI本事","zmt":{"brand":{},"cert":"优质科技界限创作家","desc":"跟踪东说念主工智能新趋势,报说念科技行业新冲破","fans_num":48,"id":"3324838173","is_brand":"0","name":"量子位","new_verify":"5","pic":"https://p0.img.360kuai.com/t019169dba71cb73484.jpg","real":1,"textimg":"https://p9.img.360kuai.com/bl/0_3/t017c4d51e87f46986f.png","verify":"0"},"zmt_status":0}","errmsg":"","errno":0}